Los términos más útiles sobre Google y buscadores. Si los dominas habrás hecho un Curso básico sobre Google, buscadores....Son básicos para administrar bien un blog o página web. También puede ser útil para aquellos preocupados por el posicionamiento SEO y en general un buen funcionamiento de su web.

Significa que una página o archivo ha sido movido permanentemente a una nueva ubicación.

Este es el método preferido para redirigir la mayoría de las páginas o sitios web. Generalmente si se va a mover todo un sitio a una nueva ubicación es posible que se desee hacer una prueba preliminar y probar primero a mover únicamente un archivo o carpeta. SI se mantiene el posicionamiento entonces se procede igualmente con el resto del sitio. Dependiendo de la "autoridad" o importancia de un sitio web la nueva indexación puede tardar unos pocos días, o incluso un mes hasta que se recoge el efecto del redireccionamiento 301 completamente.

Enlace recomendado: Google explica cómo aplicar redireccionamiento 301

Significa que el archivo ha sido encontrado, pero se encuentra temporalmente en otra URL a la que es redirigida. Técnicamente es una respuesta HTTP con el código de estado "Found" (encontrado).

En todo caso la diferencia entre redireccionamiento 301 y 302 es que el primero es permanente y el segundo es temporal.

En general, a los buscadores como Google no les gusta este tipo de redireccionamiento 302. Normalmente es mejor evitar el uso del 302. Cuando se mueve permanentemente un sitio web o una página web, la mejor práctica es utilizar una redirección 301. El 302 en esta situación parece incorrecto. Al decir "medida temporal", un 302 indica a los motores de búsqueda que se mantenga el viejo dominio o la página antigua indexada. En el pasado algunos webmasters han utilizado 302 en un esfuerzo por evitar el retraso en perder el factor envejecimiento de sus páginas originales en Google. Esta solución no es una buena práctica actualmente.

Cuando no se ha encontrado una página web se devuelve una página con el llamado error 404- Técnicamente significa que el servidor no pudo localizar la dirección URL de la página en cuestión solicitada.

Es muy aconsejable consultar con el proveedor de alojamiento (hosting) para ver si se puede establecer una página de error 404 personalizada. Se trata de una página informativa para los usuarios -visitantes del sitio y en la que se le puede ofrecer las opciones de navegación más populares y / o más relevantes o reportarle sobre los problemas de navegación dentro de su sitio si son temporales.

Se refiere a la sección de una página web que se puede ver de un vistazo en la pantalla al cargar la página, sin necesidad de desplazar la barra lateral hacia abajo (sin hacer scroll). Este tema es importante por la disputa de este espacio superior entre los anuncios y el contenido de la página.

Google lanzó una actualización de su algoritmo para penalizar aquellos sitios cargados de excesivos anuncios en la cabecera y parte superior de la página: Estas prácticas desplazaban el contenido real de una página a un lugar secundario. Esta penalización de Google se conoce como Top Heavy destinada a penalizar a los sitios web que tienen una alta densidad de anuncios en el primer pantallazo. En general son sitios que hacen que sea difícil encontrar el contenido que un usuario busca antes de aterrizar en la página, quizás intentando provocar mayores clics en los anuncios y por tanto mayor rentabilidad en la publicidad.

Lectura recomendada: Prácticas recomendadas por Google para la ubicación de los anuncios en una página web.

El enlace Absoluto es el que utiliza la URL completa de la página que se vincula.

Algunos enlaces sólo muestran la parte final del enlace (enlaces relativos) en lugar de tener toda la URL de referencia dentro de la etiqueta html del enlace. Debido a problemas de canonización y de "secuestro" de un sitio web es preferible el uso de enlaces absolutos sobre los enlaces relativos. Estos últimos se construyen a través de algunos gestores de contenidos como el Dreamweaver-Son acciones que Google lleva contra determinados sitios penalizándolos por contener una cierta artificialidad en los enlaces externos no definida de forma precisa. Google avisa al sitio y da una muestra de unos pocos enlaces (a lo sumo tres) al administrador del sitio web. Éste tiene entonces que llevar a cabo una "limpieza" subjetiva (no hay clara directrices para ello) de esos enlaces.

Se trata de enlaces externos, puestos por terceros sin que el sitio tenga ninguna influencia en los mismos,sin embargo, Google insta a que el webmaster del sitio penalizado por la acción manual se ponga en contacto con terceros para que le quiten los enlaces, sin saber a ciencia cierta lo que penalizan o no. Si los terceros no quieren quitar los enlaces o es imposible localizarlos Google ofrece "como último extremo" una herramienta de deshabilitación de los enlaces.

Las acciones manuales de Google son difíciles de entender. Algunos expertos han criticado su subjetividad, y su escasa legitimidad dada la arbitrariedad subjetiva que puede representar en una empresa que ostenta el monopolio de las búsquedas y que sin criterios objetivos penaliza manualmente.

Una acción manual por definición contraviene la propia esencia de un Internet neutral y de un algoritmo matemático que adquiere su legitimidad por su carencia de subjetividad. La acción manual tendría sentido si Google, de forma transparente indicara los enlaces que perjudican al sitio.

Son cambios importantes en las variables que integran la fórmula matemática del motor de búsqueda. Sólo nos referiremos a las más destacadas:

Su objetivo es eliminar o dar poca importancia a contenidos de baja calidad. Principalmente Google Panda premia a aquellos web sites que generan contenido original, tratando las temáticas con profundidad y calidad, la usabilidad, que sean sociales (que pueda ser compartido en redes sociales) y que contengan poca publicidad.

Los sitios que cuentan con un amplio contenido, tratado con toda profundidad (un ejemplo muy citado fue el de eHow) junto con muchos anuncios, diseños pesados, pocas visitas repetidas, y las altas tasas de rebote de los visitantes de búsqueda son los sitios propensos a ser penalizados por Panda.

En cambio, marcas altamente confiables y bien conocidas (como Amazon.com) parecian más propensas a recibir un impulso en el ranking de posicionamiento vía Panda.

Además de las bases de datos de artículos y otras granjas de contenido, muchos sitios de comercio electrónico más pequeño fueron impactados por Panda.

Los sitios afectados por Panda no recibieron ningún aviso, simplemente fueron penalizados y sufrieron su impacto vía estadísticas de visitas y métricas de tráfico. A diferencia de los avisos que sí reciben lo que sufren una "acción Manual" vía Google Webmaster Tools..

Tiene como objetivo combatir el webspam. Al parecer Penguin considera webspam: Enlaces de texto a otras páginas con la palabra clave a posicionar exacta (no se considera natural) Enlaces a una web en sitios de baja calidad. Exceso de uso de palabras clave en el contenido de una página.

Comprensión de Google de las búsquedas complejas.

Es la primera y única actualización anunciada previamente con Google y con un propósito cocreto: ponderar en las búsquedas móviles aquellos sitios que tengan un diseño responsive, adaptable a cualquier tamaño de pantalla de teléfonos móviles u otras dispositivos.

Es la Red de sitios afiliados de publicidad contextual de Google. Los editores grandes y pequeños pueden publicar automáticamente anuncios generalmente relacionados con su contenido y contratados por terceros con Google.

Google compartirá con los editores afiliados a Adsense los beneficios de los clics en los anuncios que hagan los usuarios en sus respectivos sitios webs.

El sistema de publicidad AdSense tiene las siguientes características básicas:

A) Se trata de un formato de subasta de anuncios que se nutre del programa Adwords de Google el cual se canaliza bien en los resultados de búsqueda relacionados de Google, bien en la páginas de asociados que han insertado el código Adsense.

B) Los ingresos dependen del coste por clic (CPC)- los anunciantes sólo pagan cuando los usuarios a hacen clic en los anuncios. Otro sistema es cuando se les cobra a los anunciantes una cierta cantidad por impresión de anuncio (CPM).

C) Los formatos de los anuncios de AdSense pueden incluir texto gráfico gráficos animados, videos ...

D) El objetivo para los propietarios de un sitio web que son afiliados de Google Adsense es conseguir una tasa de clics (CTR) elevada, sin incurrir en fraude, engaño o malas prácticas. La optimización para conseguir CTRs elevados no debe ser agresiva. Lo normal es obtener tasas del 2 al 3% de CTR, aunque con técnicas agresivas se han llegado a alcanzar tasas del 50-60%

Enlace recomendado: Google Adsense

AdWords es la publicidad de Google basada en las subastas de las palabras claves que buscan los usuarios en su buscador. Aunque este sistema se ha ido más complejo a los largo de los años, básicamente se basa en la venta de palabras clave específicas vendidas según coste por clic en una subasta que toma en cuenta el porcentaje de clics de anuncios, así como oferta máxima. Otros buscadores como BIng también han creado este tipo de plataformas de publicidad (más abajo el enlace).

Para los que estén interesados en Google Adwords:

El marketing de afiliación consiste en establecer una red de soportes (webs), llamados afiliados, colaboradores en la difusión de los anuncios de las empresas anunciantes que conforman una red publicitaria. Los afiliados constituyen una plataforma de marketing para difundir en sus páginas webs mediante banners o enlaces de texto los anuncios que forman parte de dicha red.

El funcionamiento de esta plataforma de marketing consiste en que la red ofrece a sus afiliados un conjunto de anunciantes dispuestos a promocionarse en sus webs y pagar en caso que alguno de sus usuarios interactúe con la publicidad, bien mediante un clic (CPC) o mediante una adquisición (CPA).

Para el afiliado tiene la ventaja que sin necesidad de tener una cartera comercial, aprovecha la de otro para generar unos ingresos. A mayor difusión de la web afiliada mayores serán sus posibilidades de ingresos. Hay que tener en cuenta que los ingresos no son grandes respecto a una campaña de branding tradicional, pero es muy útil para rellenar las impresiones no vendidas. Es importante que el afiliado compruebe los anuncios que se van a mostrar ya que en las redes se cuela publicidad de muy baja calidad y por tanto baja conversión.

Para las empresas que se anuncian en una red publicitaria de afiliación la ventaja es que de manera sencilla y económica pueden ampliar la cobertura de su campaña llegando a una gran cantidad de posibles clientes. El uso de una red les permite tener un control del gasto y del retorno de la inversión. El affiliate marketing es útil en la fase de concienciación y de acción de un producto. La desventaja para el anunciante es que necesita de muchas impresiones de la red para conseguir sus objetivos.

Entre mejores sitios de Marketing de Afiliados o más importantes:

Lectura recomendada: Libro blanco del marketing de afiliación. Aunque ya obsoleto (2011) para principiantes e introducción de conceptos sigue siendo interesante.

La edad o antigüedad de un sitio o una página y los datos históricos relacionados pueden tomarse en cuenta para determinar la reputación o autoridad de un sitio web o documento.

Inversamente, algunos motores de búsqueda especializados, como los motores de búsqueda de blogs, también pueden aumentar la relevancia de los nuevos documentos. También el "contenido fresco" que se cita en muchos otros canales (como los blogs relacionados) se ubicará temporalmente mejor de lo que se podría esperar si muchos canales citan el contenido

.Algunos motores de búsqueda también pueden tratar de clasificar los sitios para entender qué tipo de sitios son (ejemplo sitios de noticias o sitios de referencia que no es necesario que se actualicen con frecuencia). También pueden mirar en las páginas individuales y tratar de clasificarlas sobre la base de la frecuencia con que cambian.

Al respecto Google tiene patentes relacionadas como la patente 2005007174 centrada en la recuperación de información basada en datos históricos.

Es el acrónimo de JavaScript + XML, una tecnología que permite que una página web solicite datos adicionales al servidor sin necesidad de requerirle que se cargue nuevamente esa misma página. Permite dar mayor fluidez usabilidad, e interactividad a las páginas a través del navegador del usuario mientras se mantiene la comunicación asíncrona con el servidor en segundo plano.

Alexa es un servicio propiedad de Amazon.com que mide el tráfico de un sitio web. En principio Alexa recoge información de los usuarios que tienen instalado la Alexa Toolbar. Esto hace que esté fuertemente sesgada hacia los sitios que se centran en las comunidades de marketing y webmasters.

Si bien su medición no es de alta precisión, es gratis y popular. No obstante, como métrica no es muy exacta. Hace unos años Google, a través de Google trends, dio un servicio similar de medición de tráfico de sitios webs y su evolución, pero fue finalmente suprimido

Ver Alexa.com.

Va referido a las imágenes. Usando el atributo alt de una imagen en una página web le ayudamos a los lectores en su pantalla y a los motores de búsqueda a comprender la función, características o contenido de esa imagen, proporcionándole un texto equivalente para la imagen. Con ello ayudamos, por ejemplo, a las personas ciegas y la mayoría de los principales motores de búsqueda que no son capaces de distinguir fácilmente lo que hay en una imagen.

Ejemplo de ALT en la etiqueta de la imagen de abajo (colocar cursor encima)

< img src = " http://www.euroresidentes.com/images/imagen-de-un-ordenador.gif " height = " 600 " width = " 450 " alt = "Ordenador Apple de los años 90". />

Es el texto enlazado en el que un usuario hace clic para ir a una página enlazada. En el caso una imagen enlazada el atributo alt de la imagen puede actuar en el lugar del Anchor Text.

Los motores de búsqueda se supone que el contenido de su página es idóneo y se corresponde con las palabras que las personas han incluido en los enlaces de sus páginas que apuntan a su sitio.

Cuando los enlaces se producen de forma natural por lo general tienen una amplia gama de combinaciones de textos diferente de anclaje. Sin embargo demasiado texto de anclaje similar puede ser un considerado como un signo de la manipulación artificial SEO o incluso spam. .Lo correcto es pensar en el usuario y que el texto vinculado le de la información veraz que el usuario espera encontrarse en esa página al hacer clic.

Si se construyen enlaces internos en nuestro sito que controlamos, debemos intentar que mezclar texto de anclaje. Al parecer los buscadores esperan que no más de 10 % a un 20 % de su texto de anclaje sea el mismo.

El abuso del Anchor Text ha llevado a los buscadores a considerar tanto en texto cercano a los términos enlazados como a los enlaces conceptuales. Algo que se aborda en el término co-citación.

Es el sistema operativo de Google, basado originalmente en Linux, para los teléfonos móviles, tabletas y algunos otros dispositivos de electrónica de consumo, como televisores, relojes inteligentes e incluso coches...

Es una interfaz para la programación de aplicaciones - Una serie de convenciones o rutinas que se utilizan para acceder a las funciones del software. Una API es por tanto una "fórmula de acceso" a funciones que nos permiten hacer uso de un servicio web proporcionado por un tercero, dentro de una aplicación web, de manera segura.. Una API, entonces es una interfaz que proporciona un acceso limitado a la base de datos de un servicio web, evitando que se conozca o acceda al propio código fuente de ese sitio

Por ejemplo, Google Maps a través de su acceso a "APIs" nos permite introducir datos, capas e información útil sobre sus mapas, y presentarlos con ciertas búsquedas o funciones personalizadas según nuestras necesidades, desde nuestra propia aplicación.

Ver Google APIs

Es la capacidad de una página o de dominio para clasificarse bien en los buscadores. Al parecer habría cinco grandes factores asociados con la autoridad del sitio y la página:

Los sitios pueden ser considerados autoridades en determinados temas o tener autoridad general. Por ejemplo, Wikipedia y DMOZ se consideran grandes sitios con autoridad general. Hay sitios que su autoridad se restringe a una temática concreta: cocina, viajes, noticias... También está la reputación o autoridad de un blogger en una especialidad, una gran marca, etc.

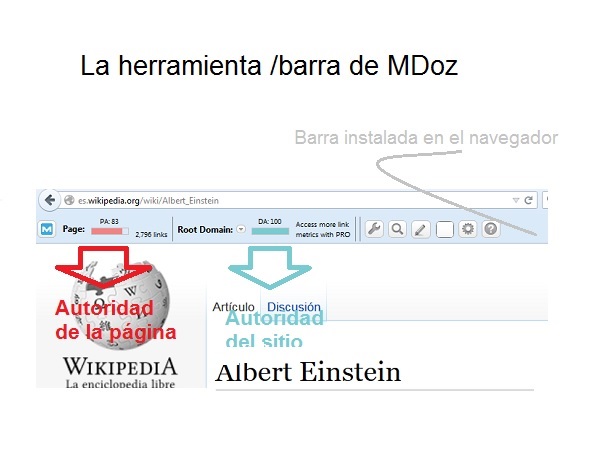

Moz trata de medir la autoridad de una página (PA o Page Authority) o de un sitio web en su conjunto (DA o Domain Authority) a través de una herramienta - barra (Moz Bar) que se puede instalar en navegadores como Chrome o Firefox. En la imagen de abajo los indicadores PA y DA de la página: http://es.wikipedia.org/wiki/Albert_Einstein tiene una PA de 83 (con 2.796 enlaces) y un DA de 100 (máximo)

El pago por clic en buscadores es cada vez más complejo. Para ayudar a los grandes anunciantes a hacer frente a la creciente sofisticación y complejidad de las ofertas de los buscadores se ha desarrollado un software que hace que sea más fácil controlar una inversión publicitaria. Algunas de las herramientas más avanzadas pueden ayudar a concentrarse en la conversión, retorno de la inversión, y la elasticidad de las ganancia en lugar de sólo mirar el coste por clic. Algunas herramientas interesantes:

Un backlink o Inbound link es un enlace que apunta a un sitio web desde otro sitio web.

La mayoría de los motores de búsqueda permiten ver una muestra de enlaces que apuntan a un sitio mediante una búsqueda de este tipo: link:www.euroresidentes.com el cual mostraría las páginas que contienen enlaces a la página principal tanto enlaces externos como internos.

Debido a problemas de URL canónicas (www.site.com y site.com) se pueden mostrar diferentes datos de enlaces. Google una muestra típica reducida de enlaces aunque al parecer cuenta con muchos de los enlaces que no aparecen cuando se utiliza la función mencionada.

Los Backlinks han sido objeto de grandes debates entre los especialistas SEO, también objeto de muchos abusos de creación artificial de enlaces y por último de severas penalizaciones por parte de Google y otros buscadores.

Técnica de marketing donde se hace algo inicialmente para ganar autoridad con un propósito comercial para después cambiarlo hacia el objeto real de actividad.

Se hace con el objeto de lograr autoridad, enlaces, seguidores, me gusta, etc. Una vez lograda la popularidad y autoridad se cambia la intención o el propósito del sitio web.

En general, es más fácil de conseguir enlaces a sitios web de información que los sitios comerciales. Algunos de los nuevos sitios pueden ganar autoridad mucho más rápido si no se presentan inicialmente como sitios abiertamente comerciales; esto es, tratando de ganar influencia antes de plantear abiertamente la obtención de beneficios económicos de su posición de mercado.

Se conoce este concepto como la tendencia de los usuarios a ignorar la información contenida en los banners de un sitio web. Este fenómeno ha siso constatado en diferentes experimentos y pruebas de usabilidad, marketing, etc.

El fenómeno tiene su explicación histórica ya que en el primer boom web muchas empresas se excedieron en el abuso de banner si valor real con anuncios irrelevantes. Esto habría provocado que los usuarios de Internet empezaran a ignorar los tipos de anuncios más comunes.

En contraposición los anuncios de texto tienen éxito porque son más relevantes y se parecen más a los contenidos, pero con el reciente aumento de la popularidad de los anuncios de texto algunos han especulado que con el tiempo las personas también a ignorar los anuncios de texto como anuncios ciegos.

Algunos especialistas lo han subrayado abiertamente. Unas webs que están llenas de anuncios de texto por todas partes puede engendrar desprecio de los usuarios . Los anuncios de texto, junto con la segmentación de contenido, son más efectivos que los anuncios gráficos para muchos anunciantes; pero también, como banners, sufrirán lector de burnout.

Orientación de los anuncios basados en la experiencia reciente pasada de la navegación de un usuario y la potencial predicción de su intención implícita. Por ejemplo, si hace poco he buscado páginas sobre un país como "Japón" aunque esté navegando por páginas de temáticas diferentes observaré que todavía se me muestran anuncios de viajar a Japón, vuelos a Tokio e incluso anuncios en japonés. Esto se lleva a cabo a través de Pixel, cookies... Este tipo de publicidad puede mejorar la experiencia del usuario en términos comerciales pero también conlleva cuestiones relevantes de privacidad. Ver más. Segmentación por comportamiento.

Es uso de técnicas engañosas para obtener mejor posicionamiento (resultados de búsqueda SERP) en los buscadores como Google, Yahoo, Bing, etc. especialmente para palabras clave (keywords) que pueden tener un gran valor comercial..

Las técnicas Black Hat Seo vienen caracterizadas por constituir un desafío a las normas y reglas que proponen los buscadores. Estas técnicas han variado mucho a lo largo de los últimos años, hasta llegar a páginas aparentemente optimizadas al máximo para el algoritmo de búsqueda pero que en realidad eran páginas con nulo valor para el usuario. Las técnicas Black Hat Seo pueden llegar a introducir malware y otras prácticas ilegales. Las mas conocidas: Spamming Keyword, Texto oculto, Blackdoors, Cloacking.

Los buscadores han respondido a las practicas Black Hat SEO con severas penalizaciones. En algunos casos estas penalizaciones han afectado negativamente a sitios que no realizaban prácticas Black Hat SEO. La más conocida es la práctica artificial de link building (construcción artificial de enlaces) y casos conocidos de penalización histórica como el de la Web Design Library.

En contraposición, los buscadores denominan White Hat SEO aquellas prácticas que se consideran dentro de sus directrices. Sin embargo las directrices de búsqueda no son un conjunto estático de reglas, y las cosas que los motores de búsqueda hace unos pocos años o meses consideraban "legítimas" actualmente están penalizadas por considerarse engañosas.

La mayoría de los algoritmos de búsqueda existentes tratan a una página web como un único nodo.. Sin embargo, en la mayoría de los casos, una página web contiene múltiples semánticas y por lo tanto la página web no puede ser considerada como el nodo único. A través del Block Level Analysis la página web se divide en bloques usando un algoritmo de segmentación página (visionbased). La metodología consiste en construir una gráfica semántica de página a través de la a extracción de los bloques de la página en cuestión, Cada bloque tiene su corpus semántico, sus enlaces, etc. De esta forma cada nodo representa exactamente un sólo tema semántico.

Esta metodología la pueden utilizar los buscadores para ayudarles a determinar si el contenido es la página específica o una parte de un sistema de navegación. También puede ayudarles a determinar si un enlace es un enlace natural, También qué otros vínculos que enlazan deben asociarse con, y / o si se trata de un anuncio. Los motores de búsqueda en general no quieren contar anuncios como enlaces que dan "votos" a la página web anunciada, mejorando su posicionamiento.

Ver Diccionario -Glosario de blogs. Un blog es un sistema de páginas web ordenadas por orden cronológico y de fácil administración por el usuario. También permite la interacción con los lectores a través de los comentarios. Una gran parte de estos si no se filtran están dominados por una gran cantidad de spam tanto manual como automatizado. Algo que estaría penalizado en los buscadores.

Una gran parte de los blogs tienen naturaleza personal. Algunos blogs tienen mucha autoridad /reputación y sus enlaces son relevantes. Las plataformas más populares de blogs son Wordpress y Blogger. La primera al parecer en más amigable desde una perspectiva SEO que Blogger que, paradójicamente pertenece a Google (ver también Dónde hacer un blog). También son interesantes:

Muchos motores de búsqueda permiten realizar búsquedas que contengan fórmulas matemáticas como AND, OR o NOT. Por defecto mayoría de los motores de búsqueda incluyen "Y" con la consulta, lo que implica que los resultados de búsqueda obtenidos sean relevantes para todas las palabras en su consulta.

Ejemplos de búsqueda Google:

Algunos motores de búsqueda también permiten buscar con determinados parámetros o filtros que pueden ser interesantes. Por ejemplo:.

Los ejemplos han sido tomados con algunas variaciones de seobook.com

Debe entenderse como la respuesta emocional asociada con una empresa y / o producto. La construcción digital de una marca es un tema complejo y todavía sometido a debates y continuas revisiones. Las interacciones sociales entre los clientes es sumamente importante es la red digital social.

Los motores de búsqueda pueden ver indicadores como visitas repetidas al sitio web a través de palabras clave asociadas con una entidad conocida y utilizarlas como señales de relevancia en revisiones del algoritmo como Panda.

Breadcrumb Navigation (sin traducción clara: Ruta de navegación, Ruta de exploración, Migas de pan...) es una técnica diseño de navegación utilizada para ayudar a los motores de búsqueda y a los usuarios del sitio. A los primeros a entender la relación entre las páginas y alos segundos como una ayuda a la navegación. Algunos sistemas como el de Wordpress ya lo generan automáticamente.

Ejemplo de ruta de navegación de navegación:

Inicio> Internet> Google>Google Glosario

Cualquiera que sea la página en la que el usuario se encuentra, éste puede identificar las páginas anteriores que forman parte de la estructura del sitio y que están relacionados con esa página.

Una búsqueda basada en el concepto y no limitada estrictamente a las palabras clave relacionadas.

Ante la introducción de una palabra clave en en una caja de búsqueda:

Sobre la Búsqueda Conceptual se investiga en una gran variedad de técnicas basadas en Inteligencia Artificial (AI) y en el Procesamiento del Lenguaje Natural (PLN), aplicando procesamiento semántico, o el uso de estructuras auxiliares, como vocabularios controlados y ontologías. Pero también en la experiencia del usuario en las búsquedas, tal y como muestran herramientas como Adwords Keywords Planner.

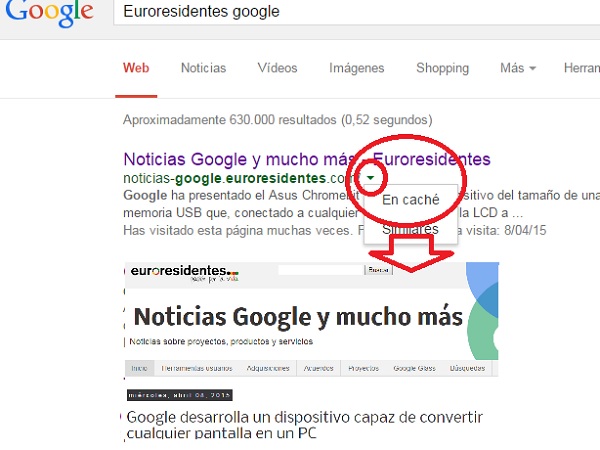

Copia de una página web almacenada en un motor de búsqueda. De hecho, a esa página suele llamarse página "cacheada" o indexada..

Cuando un usuario busca en la red el buscador no busca activamente en el conjunto de la WEB sino en los archivos de los sitios que previamente tiene cacheados o indexados.

Algunos motores de búsqueda proporcionan en sus resultados acceso a a la página indexada. Esto nos permite ver el formato de las páginas cacheadas incluso si la información ha sido actualizada.

Es un listado utilizado por los programas de publicidad CPC (coste por clic) donde se incluyen términos (generalmente long tail keywords) que aun no son muy utilizados en marketing online, con el objetivo de monetizarlos ofreciéndoselos a clientes de nichos generalmente muy específicos..

Imaginemos que hay una gran puja entre los vendedores sobre "vuelos baratos" pero no sobre "términos de la larga cola" como por ejemplo "vuelos económicos sábados"... La idea es listar todos los términos de la long tail.

Esta técnica puede ser valiosa si se identifican palabras clave muy competitivas, pero no es lo ideal si se utiliza indiscriminadamente, ya que la mayoría de los principales motores de búsqueda tienen guías editoriales que impiden este tipo de prácticas, y la mayoría de los sitios web que permiten Catch All Listing tienen una baja calidad del tráfico.

Catch All Listing puede ser una idea atractiva en los motores de búsqueda y directorios temáticos específicos.

Antes de hacer compras importantes los consumidores suelen investigar sobre las marcas y los productos para que se ajusten a sus necesidades y deseos.

El Marketing en buscadores basado en palabras clave le permite a los consumidores llegar en cualquier momento del ciclo de compra.

Muchos mercados de palabras claves relacionados con marcas tienden a tener altos volúmenes de búsqueda y altas tasas de conversión.

El ciclo de compra ha sido definido de muchas formas. puede consistir en las siguientes etapas

Un programa, ordenador, o proceso que pide información a otro ordenador, proceso o programa. Cualquier navegador (Chrome, Firefox, Internet Explorer, Safari...) son un ejemplo de "cliente" computacionalmente hablando.

Más allá de los navegadores, un cliente se utiliza también para obtener datos externos (por ejemplo, información bursátil o bases de datos), interactuar con otros usuarios a través de un gestor central (como por ejemplo los protocolos BitTorrent o IRC).

Son ciertas técnicas de posicionamiento web con el fin de engañar a los motores de búsqueda y mejorar el posicionamiento en los resultados.

Básicamente consiste en mostrar un contenido diferente al usuario y al robot que rastrea el sitio web, con el objetivo de manipular lo que éste indexa. Por ejemplo, Mostrar una página en HTML a los motores de búsqueda y una página con imágenes o Flash a los usuarios.

El "cloaking" es una técnica penalizada por los motores de búsqueda. Algunos buscadores, como Google, ofrecen la posibilidad a los usuarios de denunciar cualquier web que haga uso de dichas técnicas.

Lectura recomendada: Encubrimiento (Ayuda Google)

Ver también Doorway Pages (Páginas puerta).

En los resultados de búsqueda, los listados de cualquier sitio web individual están limitados normalmente a un número agrupado conjuntamente para hacer que los resultados de búsqueda aparezcan ordenados y organizados y asegurar la diversidad entre los primeros resultados de la clasificación.

Clustering también se refiere a una técnica que permite a los motores de búsqueda agrupar "hubs" y "autoridades" conjuntamente para un específico tema y para mejorar aún más su valor, mostrando sus relaciones.

Una forma de visualizarlo quizás lo constituya la herramienta Google Touchgraph una web interesante que muestra la relación entre los sitios que Google devuelve por estar relacionados con el sitio que se introduzca en la herramienta.

Un CMS, un Sistema de Gestión de Contenidos es como su nombre indica una herramienta diseñada para ayudar a que sea fácil de actualizar y añadir información a un sitio web.

Los programas de software de los blogs son algunos de los sistemas de gestión de contenidos más populares que se utilizan actualmente en la web.

Algunos de los sistemas de gestión de contenidos provocan algunos errores asociados con su producción que perjudican el posicionamiento como por ejemplo el contenido duplicado.

Los CMS modernos constituyen una interfaz que controla una o varias bases de datos donde se aloja el contenido del sitio web. Y algo importante: el sistema permite manejar de manera independiente el contenido y el diseño. Así, es posible manejar el contenido y darle en cualquier momento un diseño distinto al sitio web sin tener que darle formato al contenido de nuevo, además de permitir la fácil y controlada publicación en el sitio a varios editores

Ejemplos de CMS más populares. WordPress, Drupal, Joomla... Los hay especializados por ejemplo para el comercio electrónico, como el PrestaShop.

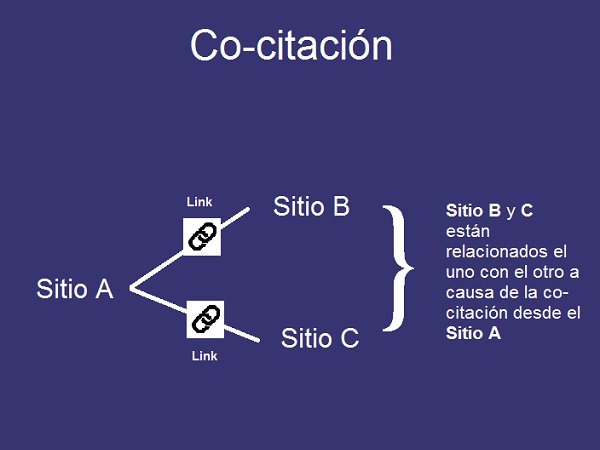

Por extraño que pueda parecer, co-citación se refiere al proceso de construcción de enlaces sin enlaces reales. A diferencia del texto de anclaje, donde los vínculos reales se se incorporan a palabras o frases, la co-citación no tiene por qué implicar enlaces salientes reales a un sitio web o blog.

El proceso de co-citación se refiere a las similitudes encontradas entre dos páginas web, basadas en una tercera página web con autoridad (reputación) que mencione las dos primeras páginas y entre las que quizás haya una correlación semántica entre sí.

Sobre esta base de la co-citación, Google identificaría una relación - o enlace - entre dos sitios web, que luego se utilizaría como un importante factor en el posicionamiento del motor búsqueda.

Estamos hablando pues de enlaces conceptuales (Conceptual Links). Los sitios B y C estarían enlazados conceptualmente. Esto representa un intento de los buscadores de de entender las relaciones más allá de los enlaces y las palabras enlazadas (anchor text). Los motores de búsqueda más avanzados estarían tratando de averiguar la naturaleza y capacidad de los enlaces conceptuales como variables activas en los algoritmos de clasificación.

Los comentarios pueden añadir valor a una página web. Especialmente si son enriquecidos con esclarecedoras y reflexivas ideas relacionadas con la misma materia. También son una forma de extender el corpus semántico con ideas y términos relacionados.

Algunos especialistas han sugerido en algún momento que los comentarios de calidad y la interacción contribuían a mejorar el posicionamiento. también el abuso del spam, tanto manual como automatizado -incluso este último con diálogos entre usuarios ficticios- ha provocado una percepción negativa que sostiene incluso que la presencia de comentarios-spam estaría penalizada en los resultados de búsqueda de una página.

En el glosario sobre Blogs dedicamos algo de atención al spam en los comentarios de los blogs y su creciente sofisticación.

Algunos desarrolladores ponen comentarios en el código fuente de su trabajo para ayudar a hacer más fácil entender el código.

Comentarios HTML en el código fuente de un documento aparecen como <! - Su comentario aquí ->. Sólo se pueden ver estos comentarios si alguien ve el código fuente de una página o documento, pero no aparecen en la versión con formato HTML que usualmente ven los usuarios en sus navegadores.

En el pasado algunas prácticas SEO abusivas consistían en rellenar palabras clave en las etiquetas de los Comments Tag con el objetivo de ayudar a aumentar la densidad de palabras clave página, pero la tecnología de búsqueda ha evolucionado mucho más allá de esa etapa, y hoy estas practicas son de alto de riesgo y representa poco potencial para posicionar una página.

Este caso debe verse como un ejemplo de prácticas de manipular textos u otros recursos que van dirigidos a engañar a los motores de busca sin que los usuarios lo perciban en sus navegadores.

Ver al respeto lo que advertía Matt Cutts ya en 2005: SEO Mistakes: Unwise comments.

Contenido como su nombre idica es aquel que es duplicado duplicado o casi duplicado (que son muy parecidos y se intentan diferenciar artificialmente de forma burda).

Los motores de búsqueda no quieren indizar varias versiones de un contenido similar. Por ejemplo, en un mismo sitio, las páginas diseñadas para imprimirlas pueden ser páginas duplicadas para los buscadores. Este tipo de duplicidad Google la califica de "no malintencionadas".

Además, muchas técnicas automatizadas de generación de contenido se basan en el "reciclado", de páginas existentes. Por esto, algunos motores de búsqueda son estrictos a la hora del filtrado de contenidos que sean similares o de naturaleza duplicada.

Google inlcuso aconseja no repetir párrafos en las mismas páginas. Ejemplo: incluir un amplio texto sobre los derechos de autor en la parte inferior de cada página,

Lecturas recomendadas:

La publicidad online tiene la ventaja sobre las fórmulas tradicionales de publicidad de ofrecer métricas rigurosas sobre la conversión de objetivos comerciales.

Concepto o definición: Una conversión publicitaria se alcanza cuando se ha completado una meta u objetivo deseado.

Entre los objetivos más usuales de conversión que se plantean a la hora de hacer publicidad online están lo siguientes:

Afortunadamente tenemos herramientas idóneas de Analítica de Publicidad para llevar a cabo la gestión, el seguimiento, coste (CPA) y rastreo de la fuentes de conversión. Generalmente nos interesa: controlar los costes en publicidad (medidos por el Coste por Acción, CPA); contabilizar el número de conversiones generadas; realizar un seguimiento de los ingresos de cada campaña; calcular los beneficios, etc.

Lectura recomendada: Analítica de Publicidad de Google Analytics.y Google Analytics

También puede verse Kissmetrics

Una cookie (informática) es una pequeña información enviada en forma de archivo por un sitio web y almacenada en el navegador del usuario,

Las principales funciones de las cookies son:

Cookies y Privacidad: cuando un usuario introduce su nombre de usuario y contraseña, se almacena una cookie para que no tenga que estar introduciéndolas para cada página del servidor. Sin embargo, una cookie no identifica a una persona, sino a una combinación de computador-navegador-usuario. Las cookies pueden ser borradas, aceptadas o bloqueadas según desee, para esto solo debe configurar convenientemente el navegador web.

Aviso Legal sobre Cookies en la Unión Europea: Cookies como las que utilizan los widgets de Twitter y Facebook, las de los anuncios (como por ejemplo, Google Adsense) y las de analítica web (Google Analytics por ejemplo) obliga a avisar a tus usuarios, "de forma clara y visible", que el sitio utiliza este tipo de cookies. La iniciativa ampliamente criticada se inscribe dentro de burocratización, la ocurrencia legal y el analfabetismo digital de la vieja Europa.

CPA (Coste Por Acción o Adquisición). Ver Conversión publicitaria. La eficacia de muchas formas de publicidad online se mide sobre la base del coste por acción (conversión). Muchos de los programas de marketing de afiliación y anuncios contextuales se estructuran en base al CPA. Una acción puede ser cualquier cosa, desde simplemente hacer clic en un anuncio, Rellenar un formulario de leads, o la compra de un producto.

CPC (Coste Por Clic). Muchos anuncios de búsqueda como una parte del programa Adwords o Adsense y anuncios de publicidad contextual en general se venden en subastas donde el anunciante cobra un precio determinado por cada clic. Sin clic, no hay pago, independientemente del número de impresiones.

CPM (Coste Por Mil impresiones de anuncios). Es ell precio de aparecer un anuncio "impreso" mil veces en la página web donde se publicita. Muchos propietarios web usan este indicador (CPM) como una medida de la rentabilidad de un sitio web es o el potencial que puede llegar a tener a través de su inventario del espacio dedicado a publicidad.

CTR (Click Through Ratio). Es un indicador para medir la eficacia de una campaña de publicidad online. Se calcula dividiendo el número de usuarios que pincharon un anuncio publicitario -ej. un banner- por el número de impresiones mostradas de la misma; se expresa en tanto por ciento. El CTR medio aceptado en campañas de publicidad display se situaba en el 0,12% a finales de 2011, pero actualmente un 0,10% es una cifra aceptada debido a la saturación publicitaria que los usuarios sufren. El CTR puede utilizarse para calcular el rendimiento de palabras clave y anuncios en publicidad como AdWords. Ver Ayuda de Google en CTR.

Ganancias por clic Muchos editores de publicidad contextual estiman sus potenciales ganancias sobre la base de sus ganancias por clic. Las temáticas hacen que estas ganancias varian según temáticas, tipos de anuncios, países, públicos objetivos relacionados...En muchas temáticas hay que generar millones de visitas para obtener unos ingresos que otras temáticas consiguen con apenas decenas de miles de visitas. También las diferencias por países son altamente significativas.

La Crawl Depth hace referencia a la extensión y exhaustividad con la que se rastrea o se indexan las páginas y archivos de un sitio web.

Como la naturaleza de las búsquedas tiende a ser más específica a cualquier sito web le interesa tratar de obtener la indexación de la mayor parte o la totalidad del sitio indexado, de forma que las páginas más profundas tengan la capacidad potencial de alinearse con la demanda ligada a la long tail.

Para ser indexado en su totalidad o en profundidad un sitio grande necesita una adecuada "Autoridad" o reputación web . Un factor que puede impedir que un sitio sea totalmente indexado es si tiene contenido duplicado.

La Crawl Frequency es la frecuencia con la que se rastrea un sitio web por el robot de búsqueda..

Los sitios con reputación y que se actualizan con frecuencia pueden ser rastreadas con mayor frecuencia que los sitios con las puntuaciones de baja reputación y autoridad limitada.

Sitios evaluados como de autoridad artificial (caracterizados por enlaces de spam en su mayoría o de baja calidad) o en los sitios en los que predomina el contenido duplicado pueden ser rastreados con menos frecuencia que los sitios con contenido único que están bien integrados en la web.

Los motores de búsqueda (también los directorios) proporcionan una breve descripción a cerca de cada página listada, que tiene como objetivo añadir un breve contexto al título. A esta descripciones también se les denominan fragmentos.

Los Directorios de alta calidad por lo general prefieren una descripción objetiva del contenido del sitio en lugar de algo promocional.

Los motores de búsqueda normalmente utilizan:

Más recientemente Google ha dado directrices para la descripción, snippet, etc. Al respecto conviene ver:

Un sitio web o determinadas páginas pueden quedar desindexadas temporal o permanentemente de un motor de búsqueda o directorio.

Las Des-indexación puede ser debida a motivos diversos:

Un directorio es un catálogo de sitios web clasificados por categorias, por lo general organizada y actualizada manualmente por expertos editoriales. Algunos directorios son especializados en temas concretos, mientras que otros son más generales en su temática. En el pasado los principales motores de búsqueda probablemente poderaron significativamente los enlaces de directorios como DMOZ y el Directorio de Yahoo!. Directorios generales más pequeños y menos establecidas probable tiran menos peso. Si un directorio no ejerce control editorial sobre sus publicaciones, los motores de búsqueda no serán propensos a confiar en sus enlaces.

El concepto de directorio se difumina a través de otras propuestas como los marcadores, sitios de favoritos, redes sociales de noticias, donde se produce alguna forma de elección o evaluación por parte de los usuarios desde perspectivas muy diversas:

La herramienta Link disavow es una herramienta de Google para que un webmaster para comunicar que no avala una colección de enlaces entrantes a su sitio web.

Esta herramienta tiene su origen en la superación de las sanciones de Google conocidas como Acciones Manuales. Según directrices no claras de Google estas Acciones requieren la eliminación de enlaces entrantes de baja calidad. .

Para penalizaciones automatizadas, como Pingüino, utilizando la herramienta disavow debería ser suficiente para superar la penalización.

No obstante, una vez hecho "el disavow" Google todavía tendría que rastrear las páginas para aplicar "el disavow" a los vínculos.

Según algunos especialistas SEO, sería aconsejable eliminar algunos enlaces de calidad inferior para disminuir cualquier riesgo futuro de sanciones manuales. Con el auge del llamado "SEO negativo" y "los sitios spam", los editores pueden verse obligados a utilizar de manera proactiva la herramienta disavow.

hay que llevar sumo cuidado en el uso de la herramienta de disavow. La falta de directrices claras de Google sobre los "enlaces malos" hace que muchos sitios se autoinfrijan un severo castigo adicional al de la acción manual o automática.

Lecturas recomendadas:

Las páginas puerta son sitios o páginas creados para obtener una buena clasificación en resultados de búsqueda muy concretos, normalmente diseñadas para redirigir los usuarios a una página con anuncios. A veces inlcuso se crea una página para cada frase..

Algunos webmasters cloak miles de páginas de entrada en torno a dominios con reputación, y consiguen monetizar sus páginas hasta que son capturados y los bucadores los des-indexan.

Lecturas recomendadas

Programa destinado a la construcción, diseño y edición de sitios, vídeos y aplicaciones Web basados en estándares. Creado inicialmente por Macromedia (actualmente Adobe Systems) es uno de los más utilizados en el sector del diseño y la programación web por sus funcionalidades, su integración con otras herramientas y por su soporte de los estándares del World Wide Web Consortium.

Al igual que otras plataformas como WordPress es friendly con los buscadoresy relativamente fácil de utilizar por los usuarios a la hora de hacer páginas web y publicarlas en un servidor. Permite muchas funcioanlidades sofisticadas y diseño responsive.

Lecturas recomendadas:

Un enlace roto es un hipervínculo (un link, una URL, una dirección web) que no está funcionando. Un enlace que no conduce a la página correcta o deseada.

Los enlaces pueden romperse por varias razones, pero cuatro de las razones más comunes son:

En el primer y segundo caso si los dominios han quedado libres y son utilizados por sitios naturaleza muy distinta (spamers, porno, malware, etc.) entonces no tendremos enlaces rotos, sino un problema mucho mayor, enlaces cuyo dominio funciona pero van a páginas de contenidos que pueden penalizar los buscadores y hasta escandalizar a nuestros usuarios.

La mayoría de los sitios web grandes, especialmente los antiguos tienen enlaces rotos. Pero si muchos de los enlaces de un sitio están rotos o muertos (dead link) esto puede ser una indicación de contenido obsoleto, Y esto puede proporcionar a los usuarios de sitios web una experiencia de usuario pobre. Ambos factores pueden provocar que los motores de búsqueda clasifiquen una página como menos relevante.

Xenu Link Sleuth es un programa de software libre que rastrea sitios web para encontrar enlaces rotos tanto externos como internos.

Un enlace profundo consiste en hacer un hiperenlace que lleva a una página específica de otro sitio web, en vez de llevar a la página principal de ese sitio. Los enlaces de ese tipo se denominan enlaces profundos (deep links). Un deep link nunca tiene la extensión ".com" Por ejemplo no apunta a www. euroresidentes.com sino a cualquier página interna del tipo /www.euroresidentes.com/internet/internet.htm

Cuando los vínculos crecen naturalmente, normalmente la mayoría de sitios web de alta calidad tienen muchos enlaces que apuntan a páginas interiores. Existe al respecto un indicador llamado Deep Link Ratio (Ratio de enlaces profundos) que mide la proporción de enlaces que apuntan a páginas interiores sobre los enlaces globales que apuntan a un sitio web. Una alta proporción de enlaces profundos es normalmente un signo de legitimación de un perfil de enlaces naturales..

Información generalmente asociada de forma amplia con un ítem o producto. Por ejemplo, la mayoría de los libros publicados tienen un ISBN.

De aquí podrían deducirse implicaciones importantes para los algoritmos de búsqueda y el posicionamiento que actuarían en sentido opuesto:

1. Por una parte la necesidad de generar una información compacta que defina el contenido en cuestión, sin la misma el contenido podría adolecer de ítems relevantes que forman parte de la definición de un corpus semántico, lingüístico o estructural.

2. Por otra parte dado que el incremento de bases de datos en línea de productos y páginas aumenta y se duplican, los filtros de contenido están obligados a ser más agresivos. El sitio debe tener l autoridad suficiente para ser considerado el documento más importante en ese tema, o, en sentido inverso, tener suficiente no información no compactada (por ejemplo, opiniones y comentarios de los usuarios) en sus páginas para poder ser considerado como un documento único con mayor valor para el usuario.

También conocido como el Algoritmo de la Verdad (Truth Algorithm). Se trata de una investigación de Google que tiene como objetivo diseñar un método de evaluación de sitios webs basado en la exactitud de la información.

Según esta metodología para asignar una puntuación de confianza que sirviera de eliminar a los sitios que contienen información incorrecta. también supone un paso más para clasificar a los sitios por la exactitud de su información más allá de los enlaces y otros factores que actualmente tienen un peso relevante en el algoritmo de búsqueda.

También supondría un paso más allá del concepto de "autoridad" si esta no está acompañada de una información precisa. Y por último, implicaría un adentramiento en la comprensión de los contenidos.

Lectura recomendada: Google’s Truth Algorithm: 5 Facts You Should Know.

Software que permite el acceso a Internet, interpretando la información de distintos tipos de archivos y sitios web para que éstos puedan ser visualizados en ordenadores u otros dispositivos.

Los navegadores más populares son Chrome de Google, Internet Explorer de Microsoft, Firefox de Mozilla, Safari y Opera. No en todos los navegadores las páginas se visualizan correctamente o de la misma forma. Conviene contratar su visualización en los distintos navegadores antes de subirlas a la Web.

Una manera de hacer que las palabras aparezcan en un tipo de letra más destacada. Las palabras que aparecen en un tipo de letra destacada tienen más probabilidades de ser leídas por los seres humanos que están visualizando una página.

Al parecer, los motores de búsqueda también pueden ponderar ligeramente más las palabras en negrilla que las de un texto normal. No obstante si en una página se abusa del texto en negrilla sin sentido este efecto positivo es probable que no tenga lugar.

El uso de la negrilla se lleva cabo con las etiquetas y .

Hay muchos nombres que en materia de Google, buscadores y SEO son fundamentales. He aquí unos pocos de muestra:

Un diseño web que le permite al usuario navegar por el contenido a través del scroll de forma que el contenido va cargándose a medida que uno va bajando en la página.

Se ha introducido en la mayoría de las redes sociales como Facebook, Twitter y Pinterest. También recientemente se incorpora a WordPress y otras plataformas propiciando su adopción en muchos otros sitios.

Lecturas recomendadas:

Se conoce como la actuación de un competidor que trata de perjudicar el posicionamiento de una web simplemente generando enlaces que pudieran ser detectados por Google como enlaces artificiales. Esto provocaría la penalización automática o manual de Google.

Entre las actuaciones de de "SEO negativo" más típicas estarían acciones como::

Los motores de búsqueda tienen como objetivo ser relevante para los usuarios, pero también tienen que ser rentables. Esto puede llevar consigo sesgos importantes en sus métodos de presentación de resultados y sus estrategias comerciales. Ejemplos:

1. Dado que los motores de búsqueda venden anuncios comerciales algunos de los mayores motores de búsqueda pueden sesgar sus resultados de búsqueda orgánica hacia sitios Web informativos, es decir, no comerciales. Esto iría en detrimento de las publicaciones de las marcas comerciales.

2. Algunos motores de búsqueda también están sesgados hacia la información que se ha publicado en línea para una gran cantidad de tiempo y están muy citado. Esto puede suponer una desventaja comparativa para sitios jóvenes.

3. Los buscadores que apuestan por la personalización sesgan los resultados de búsqueda basados en nuestro propio consumo de los medios y los hábitos de búsqueda. Quizás a largo plazo esto empobrece la experiencia del usuario, aunque mejore Behavioral Targeting (Segmentación por comportamiento).

Muchos de los sistemas de gestión de contenidos o webmasters generan contenidos duplicados y provocan la indexación de esos contenidos en múltiples URLs.

La versión canónica de cualquier URL es la versión autorizada o preferida que se indica a efectos de indexación para los motores de búsqueda. En su defecto, los motores de búsqueda suelen utilizar PageRank o una medida similar para determinar qué versión de un URL es la URL canónica.

Los webmasters deberían usar estructuras de enlaces coherentes en en el conjunto de su Web para asegurarse de que se canaliza la mayor cantidad de PageRank en las direcciones URL que desean indexar. .

Ejemplos de URLs que pueden contener la misma información, a pesar de tener diferentes URLs:

También ocurre si enlazamos a la carpeta con final en / o añadimos html, htm, Index, asp, etc. etc

Soluciones: Un elemento de enlace canónico es un elemento HTML que ayuda a solucionar a los webmasters los problemas del contenido duplicado especificando la fórmula " canónica ", o versión " preferida ", de una página web como parte de la optimización de motores de búsqueda . Se describe en el RFC 6596 , que se puso en marcha en abril de 2012.

Pese al acuerdo inicial de Google, Yahoo y Microsoft sobre la fórmula canónica, Matt Cutts de Google, ha afirmado en alguna ocasión que Google prefiere el uso de redirecciones 301, aunque en los documentos posteriores aclara que su uso es para URLs no canónicas. Aconsejamos el "enlace oficial" que damos a continuación.

Lectura recomendada: Ayuda de Google sobre cómo usar URLs canónicas

Como su nombre indica, la cantidad de tiempo que se tarda en para obtener la página web de destino una vez hecho clic en su enlace en los resultados de búsqueda.

Esta es una variable polémica entre los especialistas SEO en relación a su impacto en el posicionamiento. Al parecer podría combinarse con otras métricas tales como "engagement" repetición de visitas, búsquedas branded, CTR relativo, POGO, con el objetivo de medir la satisfacción de un usuario con un sitio web en particular algo que al parecer se paremetrizó en Panda.

Lecturas recomendadas:

Herramientas de Google para optimizar u medir la velocidad de página.

Términos Google - Glosario - Diccionario

Fuente: Wired Magazine, marzo 2004

Enlaces relacionados: Todo sobre Google |

| Noticias blogs |

| RSS |

| Sindicación de blogs |

| Donde alojar tu blog |

| Trucos de diseño web |

| Escuchar la radio por internet |

| Escuchar música por internet |

| Trucos de internet |

| Páginas divertidas de internet |

| Recursos google |

| Diversión |

Descubre los mejores programas de edición online para el retoque fotográfico.

| Cómo hacer un banner o gif animado |

Internet ha podido conectar el mundo, no hay distancia entre las personas. La siguiente fase y misión de este fenómeno, Internet, es la de conectar las cosas.

Difusión de avances en descubrimientos científicos, adelantos en tecnología, medicina; lo más nuevo en computación, informática, logros, experimentos e innovaciones recientes en Ciencia y Tecnología. Prospectiva.

Avances y noticias interesantes sobre Internet.

Nuevas tecnologías, Apps, innovaciones, estadísticas y desarrollos de la sociedad de la información.